一封给网络工程师的大模型指南 大型语言模型(LLMs)是怎样学习的

亲爱的网络工程师们:

你们好!

在日常工作中,你们精通网络架构、协议配置、流量管理与安全加固,构建并维护着数字世界的“高速公路”。当“人工智能”与“大模型”成为技术浪潮的核心时,或许你会好奇:这些看似能理解并生成人类语言的程序,究竟是如何“学习”的?它们的运作与网络工程有何异同?这封信旨在为你提供一个清晰、直观的解读,将大模型的学习过程映射到你所熟悉的网络概念中。

1. 核心类比:从“配置规则”到“学习模式”

传统网络管理依赖于工程师编写的明确规则(如ACL访问控制列表、路由协议配置)。而大型语言模型(LLMs,如GPT系列)的学习,则更像是一个基于海量数据自主归纳统计模式的过程。它不存储固定的“规则手册”,而是通过分析数以万亿计的文本数据(训练数据),学习单词、短语和概念之间的概率关联。

网络视角映射:你可以将其类比为一种高级的、自适应的“路由学习协议”。不是手动设定每条路径,而是通过观察全网流量(数据),自动学习节点(词汇)之间最可能、最有效的连接方式(关联关系)。

2. 学习三阶段:数据、训练与参数

a. 数据准备:构建“训练数据集”

如同网络设备需要输入配置信息和流量样本,LLMs的学习始于一个庞大、多样的文本数据集(来自互联网、书籍、文章等)。这个过程包括清洗(去除噪声、错误)、格式化(分词、向量化),相当于为模型准备了结构化的“学习素材”。

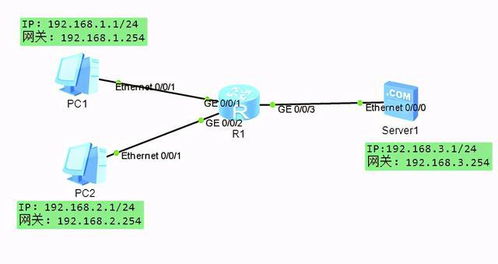

网络视角映射:这类似于在网络仿真或实验室环境中,收集并预处理各种真实的网络流量日志、协议数据包,为后续的分析或模型训练做准备。

b. 模型训练:调整“网络权重”

模型的核心是一个由多层“神经元”(数学函数)构成的复杂神经网络,其行为由数百万甚至数千亿个参数(权重)决定。训练过程就是通过算法(如梯度下降)反复调整这些参数:

1. 模型根据当前参数对输入文本做出预测(例如,预测句子中下一个词)。

2. 将预测结果与真实数据(已知的下一个词)进行比较,计算“损失值”(预测错误的程度)。

3. 通过反向传播算法,将损失值沿着网络层反向传递,并微调每一个参数,以减少下一次预测的损失。

这个过程在庞大的数据集上迭代数十万甚至数百万次。

网络视角映射:这非常像动态路由协议(如OSPF、BGP)的收敛过程。路由器最初不知道最优路径(参数初始化为随机值)。通过持续交换链路状态信息(输入数据)和计算路径开销(计算损失),不断更新自己的路由表(调整参数),最终整个网络(模型)达到一个稳定、高效的状态(收敛),能够为数据包(新的输入查询)选择最佳路径(生成合适的文本)。

c. 模型输出:生成与推理

训练完成后,模型参数固定下来。当用户输入一个提示(prompt)时,模型根据已学习的概率分布,计算并生成最可能的词序列作为回应。它没有“记忆”具体训练数据,而是基于参数所编码的抽象模式进行“推理”。

网络视角映射:这类似于一台配置完成的交换机或路由器,收到一个新的数据包(用户查询)后,基于其转发表或路由表(训练好的参数),无需再次全网学习,即可迅速决策并将其转发到正确的端口或下一跳(生成连贯的文本回复)。

3. 与网络工程的交叉点与启示

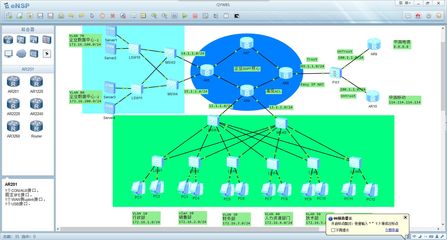

- 自动化与智能化:正如SDN(软件定义网络)和基于AI的网络运维(AIOps)旨在让网络更智能、更自适应,LLMs的学习范式展示了如何通过数据驱动而非纯手动规则来实现复杂系统的自动化。理解其原理,有助于你思考如何将类似的学习能力应用于网络流量预测、异常检测或安全策略优化。

- 数据的重要性:模型的性能极度依赖于训练数据的质量和数量。同样,网络分析、策略制定和故障排查也日益依赖高质量的网络遥测数据(Telemetry)。数据的收集、处理和分析能力是两者共同的基础设施。

- “黑箱”与可解释性:LLMs的决策过程复杂,常被视为“黑箱”。网络管理中也存在类似挑战(如复杂的故障根因分析)。了解模型的学习机制,能帮助你更好地理解AI系统的能力边界和潜在风险,在引入相关技术时做出更明智的决策。

- 提示工程 vs 网络配置:与通过精确命令行配置网络设备类似,通过精心设计提示词(Prompt Engineering)可以更有效地“引导”LLMs输出符合预期的结果。这是一种与智能系统交互的新技能。

###

大型语言模型的学习,本质上是利用海量数据和巨大算力,对一个超大规模参数网络进行概率优化,从而捕获人类语言和知识中的深层模式。它并非魔法,而是一门工程与统计相结合的精密科学。

作为一名网络工程师,你对复杂系统、协议交互和数据流有着深刻的理解。这种系统思维正是理解AI时代的基石。希望这封信能帮助你在构建物理与虚拟网络的也对正在重塑世界的“智能模型网络”建立起清晰的认识。当网络与AI更深地融合时,你的专业知识将变得更加不可或缺。

祝工作顺利,探索愉快!

此致

敬礼!

一位关注技术融合的同行

---

延伸思考:你可以尝试将你日常处理的网络策略、QoS配置或安全规则,想象为一种需要被AI模型“学习”的模式。这或许会为你的工作带来全新的优化视角。

如若转载,请注明出处:http://www.yanyunsc.com/product/58.html

更新时间:2026-02-25 03:22:37